详细介绍

| 品牌 | 其他品牌 | 产地 | 国产 |

|---|

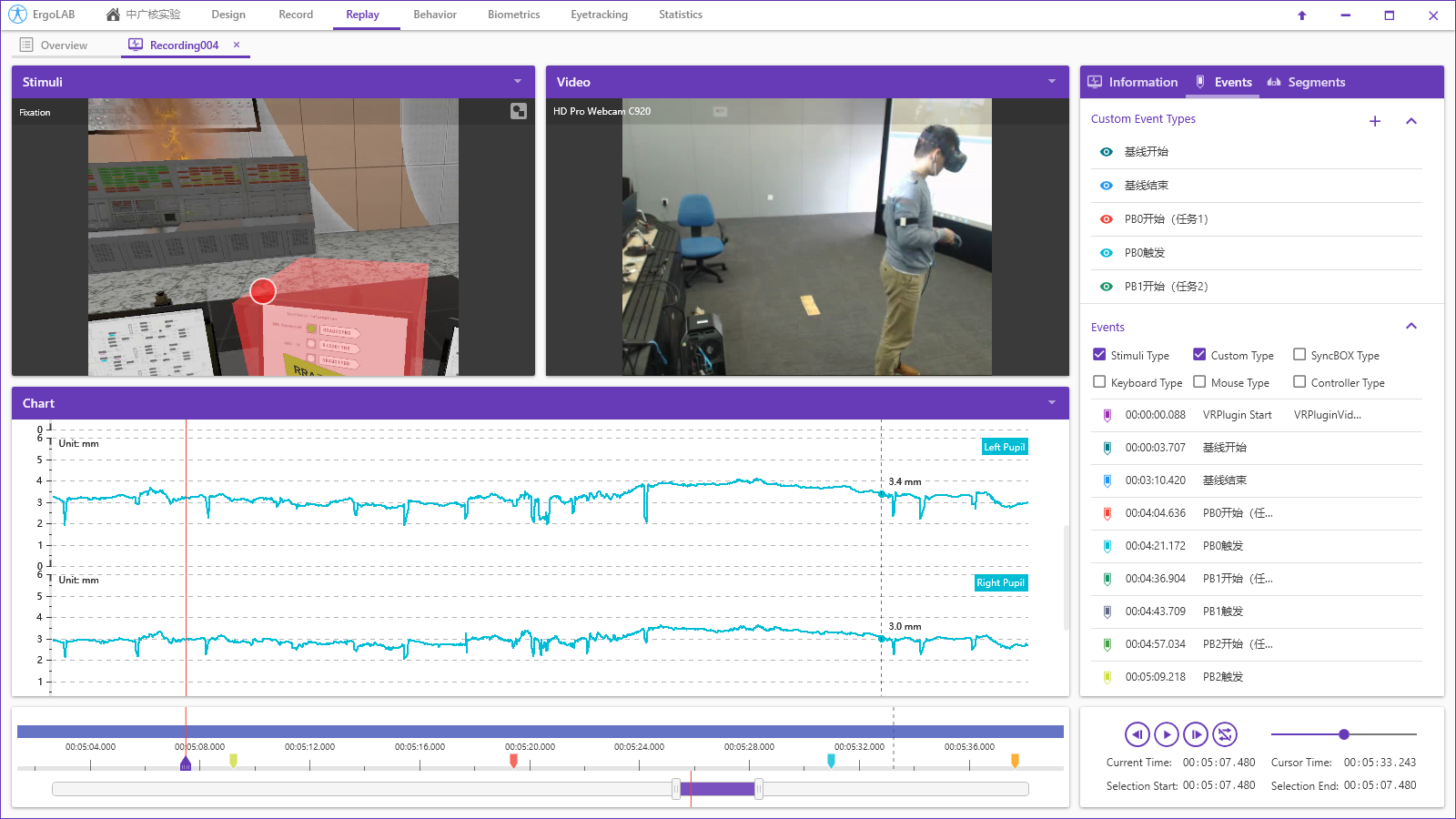

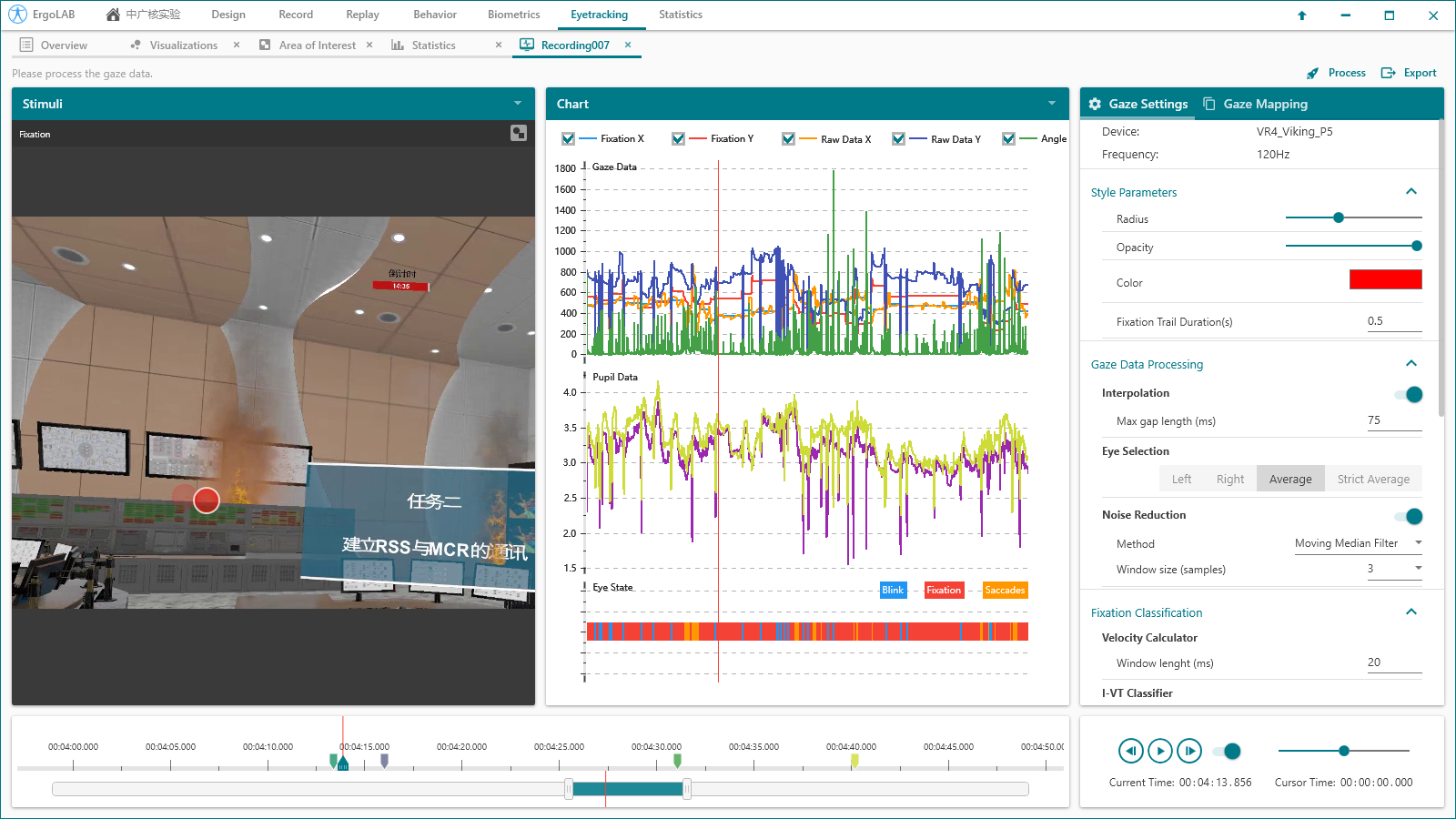

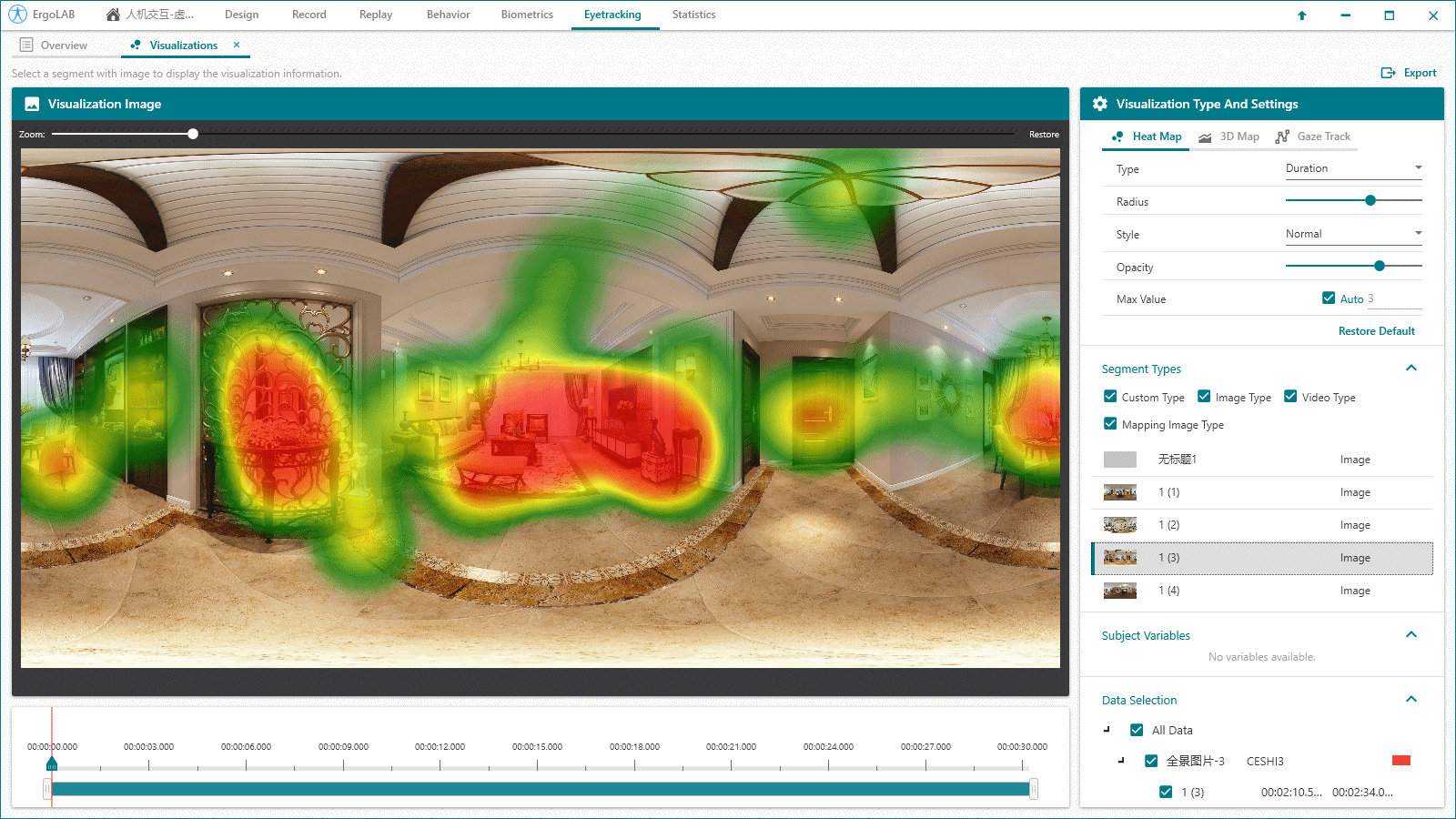

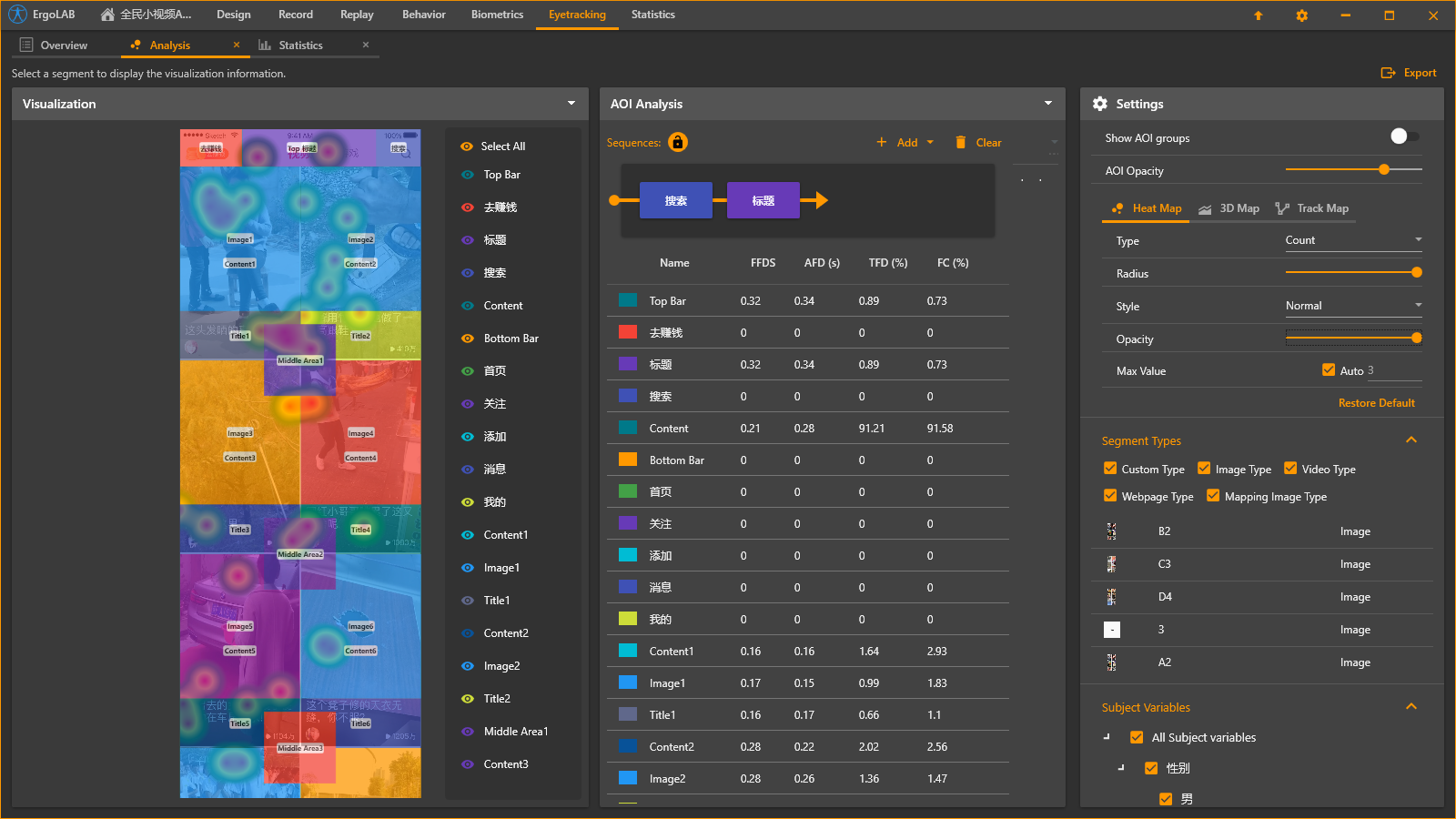

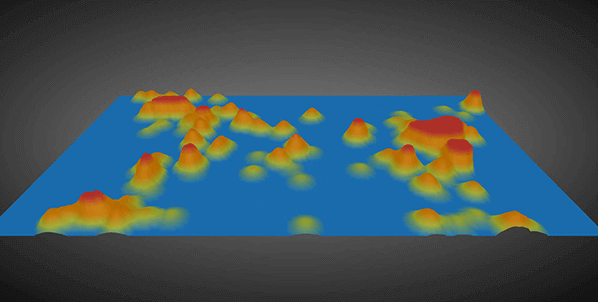

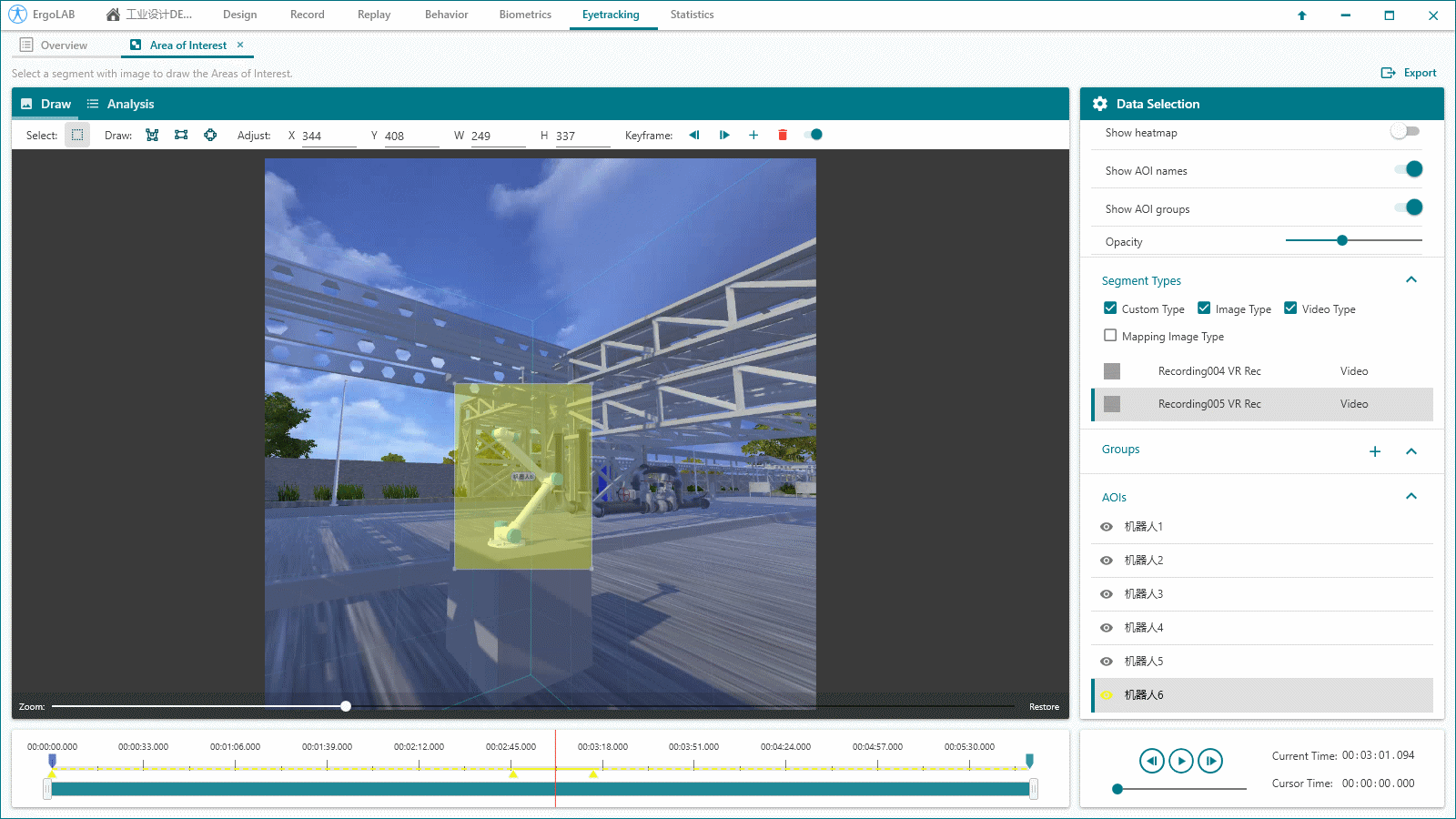

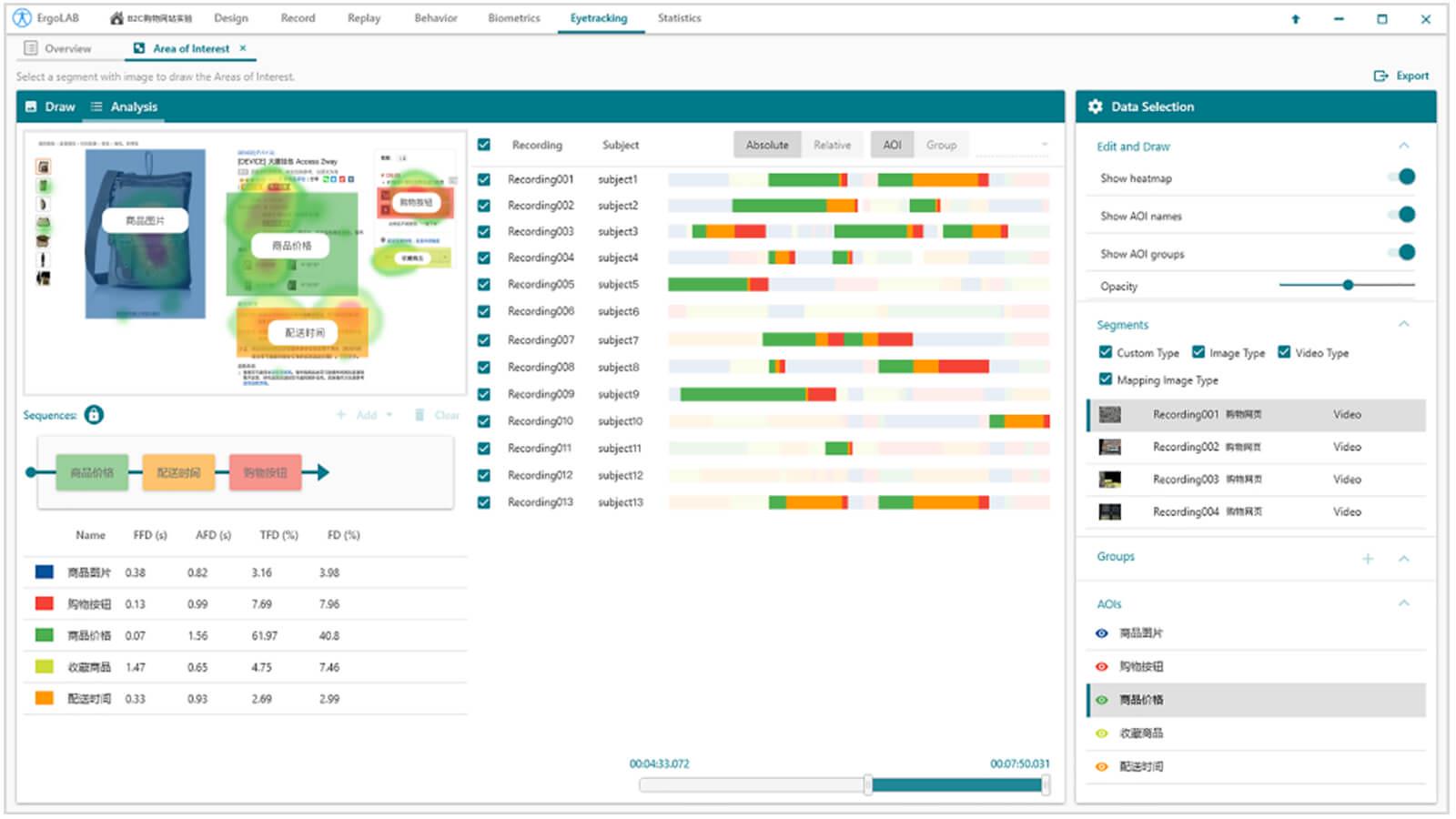

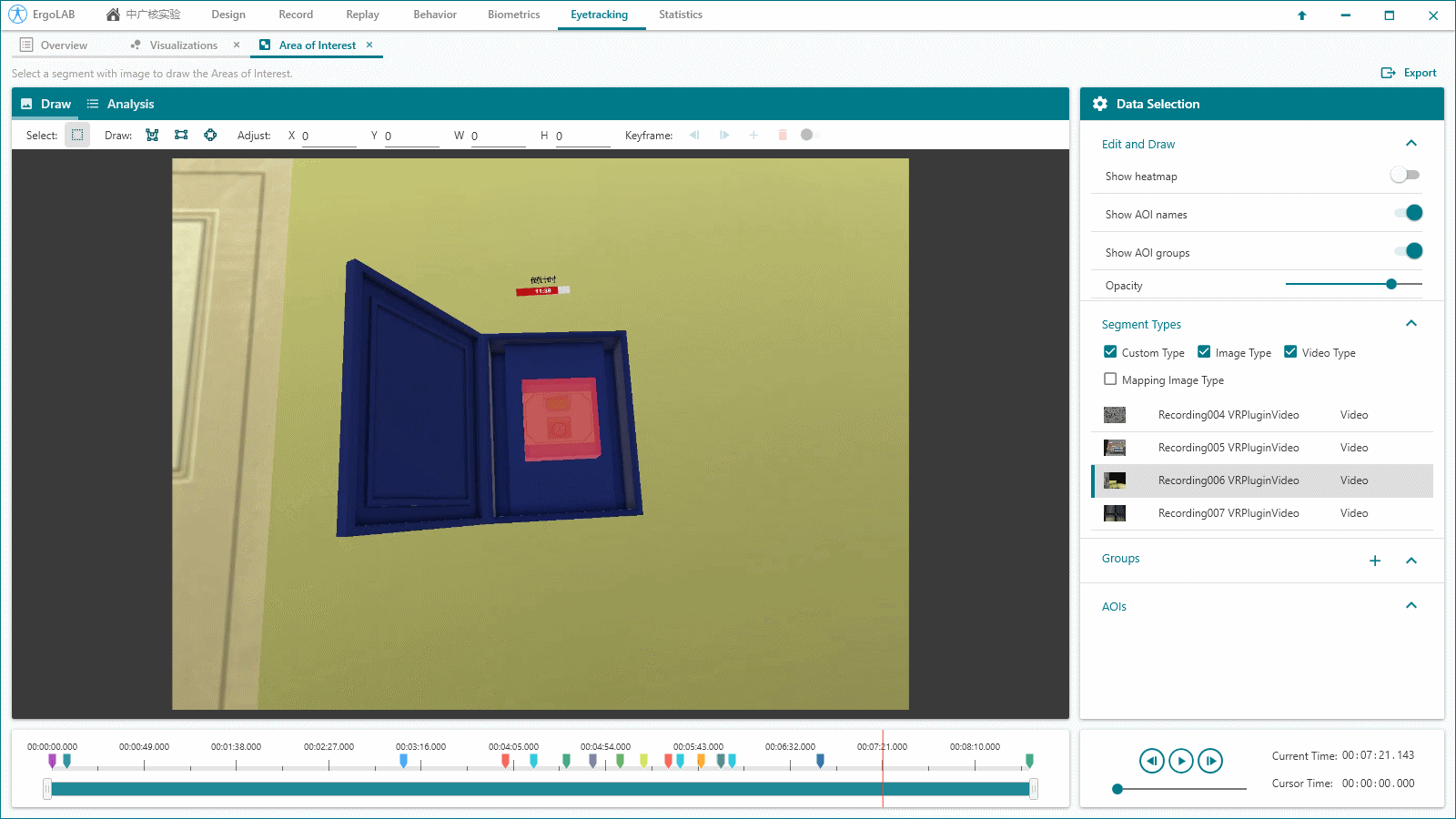

ErgoLAB Eyetracking眼动追踪模块,通过红外光反射原理测量眼睛运动过程,采用高精度的眼动追踪元件同步记录个体的眼动轨迹、视线变化、眼动状态、头部姿态等数据,进而分析视觉加工特征,了解人们感知其周围事物的视觉方式以及驱使人们作出决策的因素,在多种视觉刺激和环境下开展人类行为研究。

ErgoLAB人机环境同步平台采用多模态数据时钟同步技术,平台可完成完整的实验和测评流程,包括项目管理-试验设计-同步采集-信号处理-数据分析-人因智能评估-可视化报告,支持基于云架构技术的团体测试和大数据管理。

ErgoLAB人机环境同步平台采用主客观结合多模态数据同步采集与多维度验证的方法,数据实时同步种类包含大脑认知数据(EEG/BCI脑电仪与脑机接口边缘计算设备、fNIRS/BCI近红外脑成像仪),视觉数据(Eyetracker眼动仪与视线交互系统),生理数据(生理仪含:GSR/EDA、EMG、ECG、EOG、HRV、RESP、TEMP/SKT、PPG、SpO2),行为观察、肢体动作与面部表情(基本情绪、情绪效价、微表情等)数据、生物力学数据(拉力、握力、捏力、压力…),人机交互数据(包含人机界面交互行为数据以及对应的键盘操作,鼠标点击、悬浮、划入划出等;移动终端人机交互行为数据以及对应的手指轨迹操作行为如点击、缩放、滑动等;VR终端界面人机交互行为数据及对应的双手操作拾取、丢弃、控制,VR空间行走轨迹)、以及多类型时空行为轨迹数据采集(包括室内、户外、以及VR环境不同时空的行走轨迹、行车轨迹、访问状态以及视线交互、情感反应、交互操作行为等数据实时同步采集)、以及作业空间及作业环境数据(温度、湿度、噪音、光照、大气压、湿度、粉尘等)等客观量化数据;为科学研究及应用提供完整的数据指标。

将人工智能技术引入人因工程研究工具,人因工程行业更加深度,使得实验环境不会受限于某一种设备或数据指标,采集分析不同典型行业或学科专业的人-机-环境系统交互过程中自然状态下的人类行为数据,获取更接近真实人员状态的数据。平台还提供覆盖科研实验全流程的功能模块,包括项目管理、实验设计、同步采集、数据分析、综合统计和可视化报告,结合ErgoAI人因智能边缘计算平台为多模态人机环境研究提供一站式人因工程+人工智能解决方案。以ErgoLAB人机环境同步平台和ErgoAI人因智能边缘计算平台为核心的多模态同步人因智能解决方案大大提高了实验结果的信效度,同时节省了研究的人力、物力、时间,提高了研究与测评的整体效率。

基于ErgoAI人因智能多元时序算法底座与人因工程人机环境数据库,构建人员特定状态的预训练模型,配合高灵活度的训练方案管理功能,用户能够在统一环境中高效构建和优化模型。 从而实现对人员状态的精准实时评估与预警,如负荷状态、应激状态、疲劳状态、情景意识和注意能力等。

北京津发科技股份有限公司是专精特新重点小巨人,知识产权优势企业、高新技术企业、科技型中小企业;旗下包含北京人因智能工程技术研究院和北京人因工程设计院等科技研发机构,并联合共建了北京市企业技术中心、北京本科高校产学研深度协同育人平台、苏州市重点实验室、湖南省工程实验室、山东省工程研究中心等多个科技创新平台。

津发科技承担和参与了多项国家重点研发计划、工信部高质量发展专项、国家自然科学基金等课题基金。担任全国信标委XR扩展现实标准化组副组长单位,工信部元宇宙标准化工作组关键技术组联合组长单位;津发科技创新研发了国产化自主可控的人因工程与人因智能边缘计算系列信创产品与技术,荣获多项省部级科学技术奖励;津发科技主持和参编国际/国家、行业/团体标准20余项、荣获30余项省部级新技术新产品认证,全球申请砖利超过500项、100余项国际和国家注册商标、130余项国家软件著作权;已服务全国高等院校和装备科技工业科研院所应用示范,并已支撑国内科研学者和科技工作者发表中英文学术论文超过1000篇。

电话

微信扫一扫